Após um afro-americano ser detido equivocadamente devido um erro em um programa de reconhecimento facial, entidades de defesa social e Racial norte americanas apresentaram queixa, formalmente, contra o programa e a empresa que o desenvolve. Segundo a União Americana das Liberdades Civis (ACLU), que apresentou uma queixa em seu nome em 24 de junho, “embora este seja o primeiro caso conhecido, ele provavelmente não é a primeira pessoa a ser detida e interrogada erroneamente com base em um problema de reconhecimento facial”.

O caso aconteceu em janeiro deste ano. Robert Williams foi preso em Detroit e passou 30 horas em detenção porque um programa concluiu de modo equivocado que a foto em sua carteira de motorista e a imagem de um ladrão de relógio capturado por câmeras de vigilância eram idênticas.

De acordo com Joy Buolamwini, fundadora do grupo Algorithmic Justice League, o caso revela “como o racismo sistêmico pode ser codificado e refletido na inteligência artificial (IA).

Metodologia

A IA se baseia no aprendizado automatizado dos dados inseridos pelo programador, que a máquina analisa. Se a matéria-prima for enviesada, o resultado será distorcido.

Um estudo do Instituto de Tecnologia de Massachusetts, publicado em fevereiro de 2018, revelou fortes imprecisões nos principais programas de reconhecimento facial quando se trata de distinguir rostos por grupo populacional, com taxas de erro inferiores a 1% para homens brancos e de até 35% para mulheres negras.

Binóculos e arma

Nicolas Kayser-Bril, da ONG Algorithm Watch, publicou um Tuite e, nele, mostrou que o programa de análise de Imagens Google Vision avalia um termômetro nas mãos de uma pessoa branca como um binóculo e, nas mãos de um homem negro, como uma arma.

Segundo Nicolas, a avaliação do Google Vision “deve-se provavelmente ao fato de as imagens usadas no banco de dados que incluíam negros estarem mais frequentemente associadas à violência do que as dos brancos”. Em pronunciamento, o Google reconheceu que o resultado é “inaceitável”.

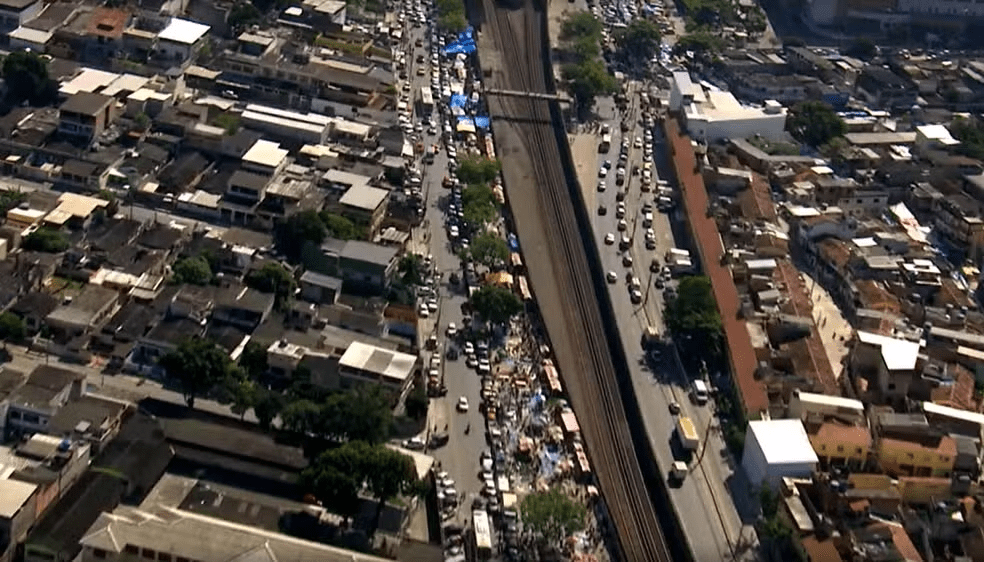

Programas do tipo, no entanto, são vendidos para empresas e governos em todo o mundo, e não apenas por gigantes do setor de tecnologia. “Isso dificulta a identificação das condições sob as quais o conjunto de dados é coletado, a qualidade das imagens e como o algoritmo foi criado”, diz Seda Gürses, pesquisadora da Universidade de Tecnologia de Delft, na Holanda.